本記事では、2025年8月7日に開催されたイベント「GitHub Copilotの全体像と活用のヒント AI駆動開発の最初の一歩」の内容をお届けします。イベントでは『Visual Studio Code 実践ガイド』の著者である、Atsushi Morimoto (@74th)氏が登壇。GitHub Copilotの基本から、AIと人間が協調する未来のコーディングスタイルまで、その活用術を詳しく解説いただきました。

また、イベント当日に回答しきれなかった質問についても、本記事にて回答いただいています。ぜひ本編のアーカイブ動画とあわせてご覧ください。

Morimoto氏は、AIコーディングの世界は日々変容しており、今回の内容は当日時点の最新情報であること、イベントではVisual Studio Code(VS Code)を例として挙げる点を前置きしつつ、GitHub Copilotの多岐にわたる機能を紹介しました。

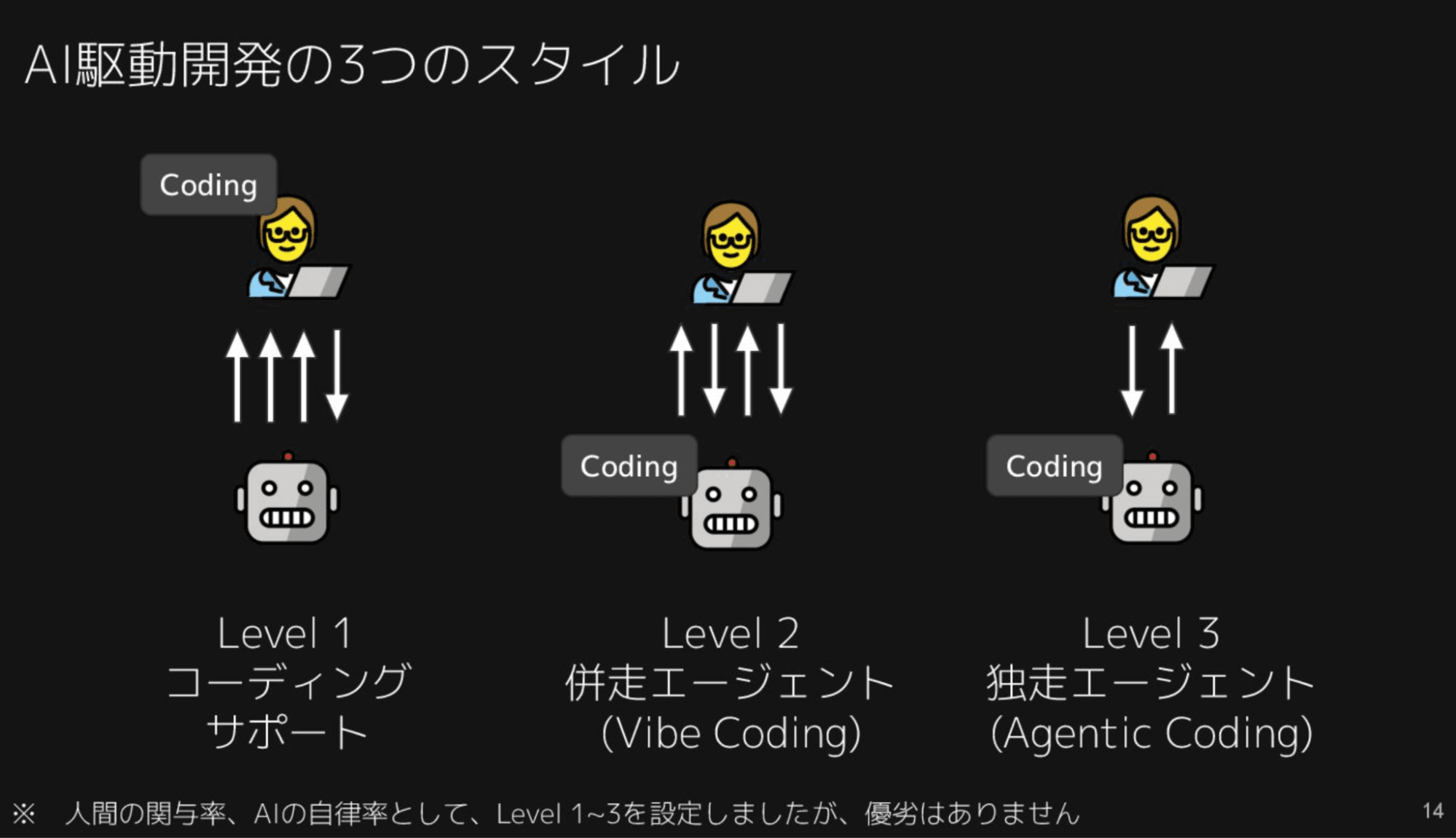

GitHub Copilotを活用する、AI駆動開発の3つのスタイル

GitHub Copilotの活用術は、大きく3つのAI駆動開発スタイル(レベル)に分けられます。これらは優劣ではなく、「人間の関与率」と「AIの自立率」をもとに設定されており、それぞれの状況に応じた活用法として示されました。

レベル1 コーディングサポート

人間がコーディングの主体で、AIがサポートする「コーディング支援」 。このレベルでは、人間の集中力を途切れさせずにAIの支援を得ることがGitHub Copilotで最も意識されている点です。

コード補完

前後の文脈を読んで、続くコードを予測・補完し、Tabキーで確定できます。例えば、Pythonで日付を扱う関数を作成する際、コメントを書くだけで関数名を提案したり、型情報を加えることで次の定義を提案したりします。

また、プロパティの追加など人間が忘れがちな関連箇所の修正を提案する「Next Edit Suggestions」機能も便利です。構造化補完のコツは、メソッド名やコメントを説明的に記述すること、Pythonではメソッドのパラメーターに型ヒントを与えること、参照してほしいファイルを別タブで開いておくことなどが挙げられました。